今天必须给你们唠唠科研界的一项超酷新成果 ——Flow-GRPO!这东西可不得了,它就像是给图像生成模型打了一针 “超级进化剂”,直接让它们从 “青铜” 一路飙升到 “王者”。想知道它是怎么做到的吗?快搬好小板凳,听我细细道来!

图像生成模型的 “成长烦恼”

现在的图像生成模型,比如基于流匹配(Flow matching)的那些,理论基础那叫一个扎实,生成的高质量图像也让人眼前一亮。但它们也有自己的 “小烦恼”,遇到复杂场景,像要安排好多物体、处理各种属性和关系,或者是在图像里准确渲染文本的时候,就有点 “抓瞎” 了。

论文地址:https://www.arxiv.org/pdf/2505.05470

项目地址:https://github.com/yifan123/flow_grpo

而在线强化学习(online RL)在提升大语言模型推理能力方面,那效果是杠杠的。可之前大家主要把 RL 用在早期的扩散生成模型,还有像直接偏好优化这类离线 RL 技术上,却很少有人探索在线 RL 能不能给流匹配生成模型带来新突破。这就好比明明有一把很厉害的钥匙,却没人想到去开这扇门。现在,Flow-GRPO 就来 “撬门” 啦!

用 RL 训练流模型,那挑战可不小。首先,流模型的生成过程就像一条设定好的轨道,基于确定性的常微分方程(ODE),一路按部就班,在推理的时候没法随机采样。但 RL 呢,就像一个好奇宝宝,得靠随机尝试不同的行动,再根据反馈来学习。这俩的 “脾气” 完全不一样,一个要规规矩矩,一个要到处探索,怎么能凑到一块呢?

其次,在线 RL 训练得高效采样收集数据才行,可流模型生成每个样本都要折腾好多迭代步骤,就像蜗牛爬一样慢,采样效率低得可怜。模型越高级、越复杂,这个问题就越严重,简直是 “雪上加霜”。所以,要想让 RL 在图像或视频生成这些任务里发挥作用,提高采样效率就成了关键中的关键。

Flow-GRPO 来 “救场” 啦!

为了解决这些难题,Flow-GRPO 闪亮登场!它就像一个超级 “魔法工具箱”,里面装着两个神奇的 “魔法” 策略。

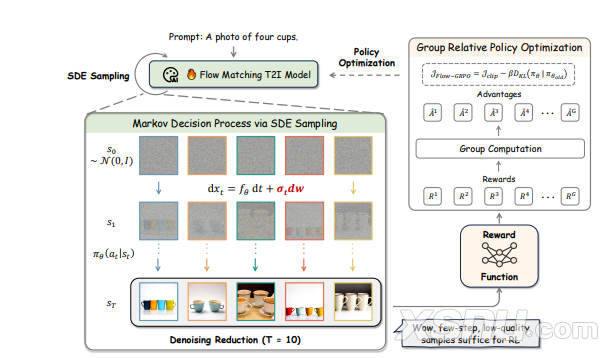

第一个魔法是 “ODE 到 SDE 转换”。这就好比把一辆只能在固定轨道上行驶的火车,改装成了能在各种道路上自由穿梭的汽车。Flow-GRPO 把原本确定性的常微分方程,转变成了随机微分方程(SDE),而且还能保证在每个时间步都和原来模型的边际分布一样。这样一来,就给模型引入了随机性,让它能像 RL 需要的那样去探索不同的可能性。想象一下,以前模型生成图像就像在一条直直的路上走,现在有了这个转换,它就能在各种不同的小路上探索,找到更合适的生成方式,是不是很神奇?

第二个魔法是 “降噪减少策略”。训练的时候,Flow-GRPO 就像一个聪明的 “时间管理大师”,它减少了降噪步骤,这样就能快速收集训练数据。但在推理的时候,它又会恢复到原来完整的降噪步骤,保证生成高质量的样本。这就好比跑步,训练的时候为了快速适应环境,就先小步快跑;比赛的时候,再按照正常的节奏大步跑,既能保证速度,又能保证质量。

Flow-GRPO 实战表现如何?

Flow-GRPO 到底有多厉害?研究人员用它在各种文本到图像(T2I)的任务上做了测试,结果简直惊艳!

在组合图像生成任务上,用 GenEval 基准测试来评估。这任务可不简单,得精确安排物体、控制属性,就像搭乐高一样,每个零件都要放对地方。Flow-GRPO 让 Stable Diffusion3.5Medium(SD3.5-M)模型的准确率从63% 一路飙升到95%,直接把 GPT-4o 模型都给比下去了!以前模型生成的图像,可能物体数量不对,颜色、位置也乱七八糟,现在有了 Flow-GRPO,这些问题都迎刃而解,生成的图像就像被施了魔法一样精准。

视觉文本渲染任务中,SD3.5-M 模型在 Flow-GRPO 的加持下,准确率从59% 提高到了92%。以前模型可能会把文本渲染得歪歪扭扭、缺胳膊少腿,现在却能准确无误地把文本呈现在图像里,就像给图像配上了最完美的文字说明,效果提升不是一星半点。

在与人类偏好对齐的任务里,Flow-GRPO 同样表现出色。用 PickScore 作为奖励模型来评估,它能让模型生成的图像更符合人类的喜好。而且,在提升能力的同时,几乎没有出现奖励作弊的情况。啥是奖励作弊呢?就是有些模型为了提高奖励分数,牺牲了图像质量和多样性,生成的图片要么模糊不清,要么千篇一律。但 Flow-GRPO 不一样,它就像是个 “正义使者”,保证图像质量和多样性的同时,还能让奖励分数蹭蹭往上涨。

研究人员还对 Flow-GRPO 进行了各种分析。比如说,在处理奖励作弊问题上,他们尝试了好多方法。一开始把各种奖励模型组合在一起,结果发现图像出现了局部模糊、多样性降低的问题,就像给美丽的风景图蒙上了一层雾,啥都看不清。后来用 KL 约束这个方法,效果就好多啦。调整好 KL 系数后,既能优化任务特定的奖励,又不会损害模型的整体性能,就像给模型找到了一个完美的 “平衡点”。

还有降噪减少策略的效果分析。减少训练时的数据收集时间步长,从40步减少到10步,结果发现训练速度提高了4倍多,而且最终的奖励分数一点也没受影响。就好比开车,以前要慢悠悠地开好久才能到目的地,现在换了条更顺畅的路,一下子就到了,还不耽误事儿!

噪声水平对模型也有影响。SDE 里的噪声水平如果设置得合适,就能提高图像的多样性和探索能力,对 RL 训练特别有帮助。但要是噪声太大,图像质量就会下降,就像往一幅精美的画上随意泼墨,好好的画就毁了。研究发现,把噪声水平设置在0.7左右的时候效果最佳,能在保证图像质量的同时,让模型更好地探索各种可能性。

Flow-GRPO 的泛化能力也很强。在一些没见过的场景测试中,它能准确捕捉物体的数量、颜色和空间关系,就算是没训练过的物体类别,它也能应对自如。从训练生成2-4个物体,到测试时生成5-6个物体,它都能轻松搞定,就像一个学习能力超强的学生,举一反三,啥题都会做!

未来展望与挑战

虽然 Flow-GRPO 在文本到图像的任务里表现得非常出色,但研究人员并没有满足于此。他们已经把目光投向了更广阔的领域 —— 视频生成。不过,这也带来了一些新的挑战。

首先是奖励设计。在视频生成里,简单的奖励模型可不够用了,得想出更复杂、更有效的奖励模型,才能让生成的视频既真实又流畅。这就好比给电影打分,不能只看画面好不好看,还要考虑剧情、音效等好多方面。

其次是平衡多个奖励。视频生成要优化好多目标,像真实性、流畅性、连贯性等等,这些目标有时候就像几个调皮的小孩,各有各的想法,很难平衡。研究人员得想办法让它们 “和谐共处”,这可不容易。

最后是可扩展性。视频生成比图像生成更费资源,就像吃得多的 “大胃王”。要把 Flow-GRPO 应用到视频生成中,就得找到更高效的数据收集和训练方法,不然 “资源小水管” 可满足不了它的 “大胃口”。

但这些挑战并不能阻挡 Flow-GRPO 前进的脚步。相信在研究人员的努力下,未来 Flow-GRPO 不仅能在图像生成领域继续发光发热,还能在视频生成等更多领域创造奇迹,给我们带来更多的惊喜!说不定以后我们看的电影、玩的游戏里的画面,都是 Flow-GRPO 帮忙生成的呢!让我们一起拭目以待吧!